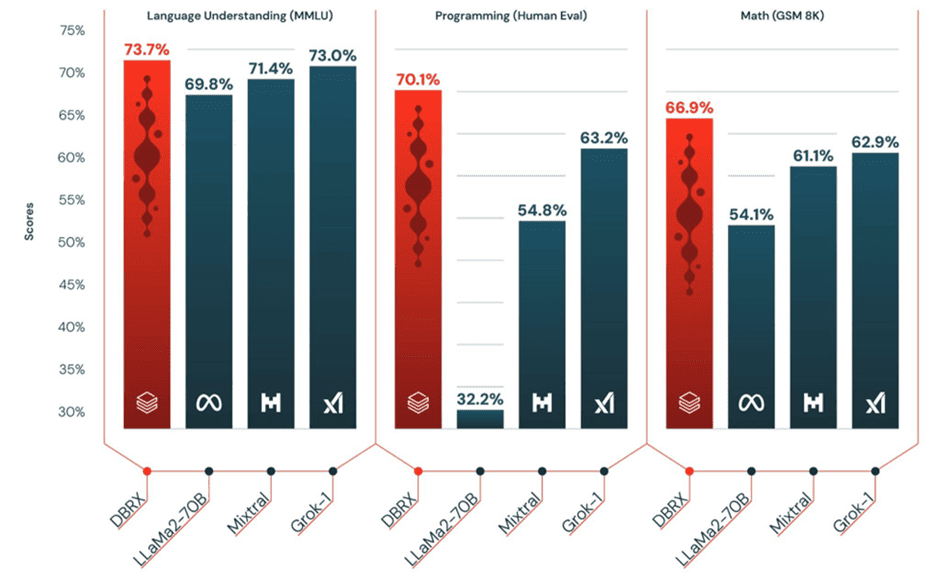

Het nieuwe general purpose large language model moet organisaties helpen generatieve AI-apps te realiseren die zeer goed presteren. Databricks wil dit bereiken door DBRX te laten vertrouwen op een mixture-of-experts (MoE)-architectuur, gebaseerd op het open-source project MegaBlocks. MoE adresseert met name de beperkingen van GPT-achtige architecturen (dense modellen) door computationele lagen op te splitsen in […]